Qu'est-ce que ChatGPT et comment il est entraîné

ChatGPT est l'IA générative de loin la plus utilisée. Mais comment elle fonctionne ? Répondre à cette question te permet de mieux l'utiliser au quotidien.

ChatGPT est le plus connu des IA générative et il compte pas moins de 100 Millions d'utilisateurs active en 2024. Mais au fond, ce n'est peut-être pas clair pour toi ce qu'il est vraiment et comment il a été conçu.

Il me semble important de connaître son fonctionnement et la manière dont il a été créé pour apprendre à bien servir notamment si tu veux utiliser ChatGPT en tant qu'architecte ou professionnel de l'architecture.

ChatGPT est une IA, de la famille des LLM, c'est-à-dire un Large Language Model.

C'est-à-dire :

- qu'il est grand et pour être grand, il est très grand... très, très grand

- qu'il est spécialisé dans le langage naturel : sa compréhension et sa restitution

Un réseau de neurone inspiré du cerveau humain

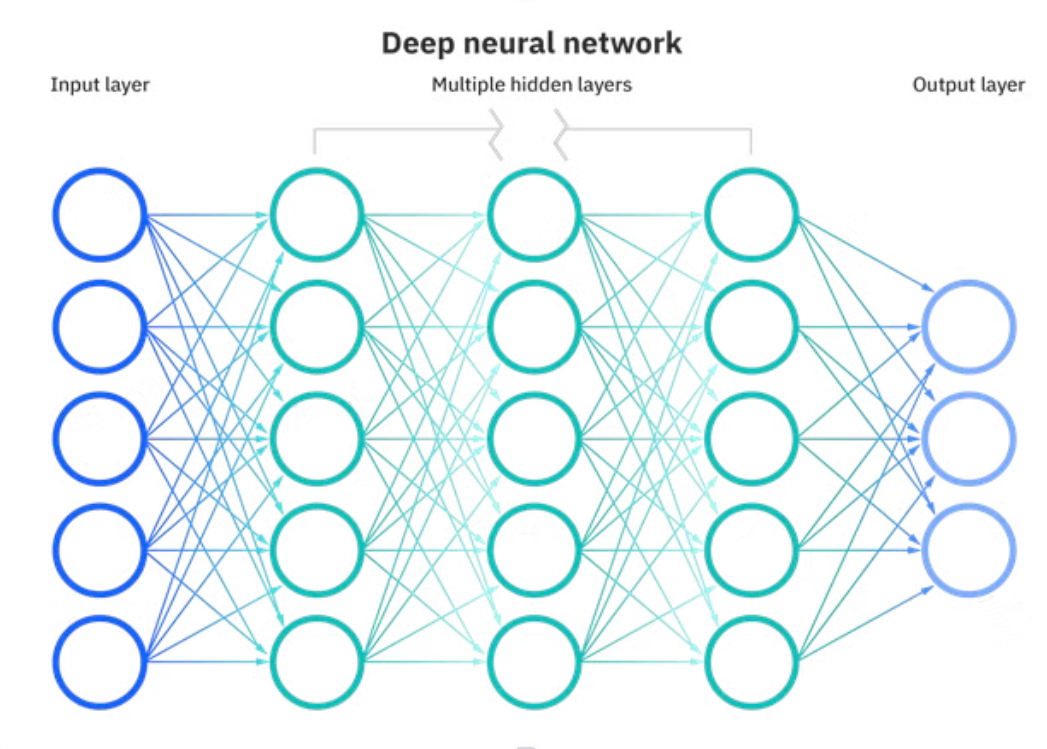

Les LLM sont des IA qui sont basées sur ce qu'on appelle un réseau de neurones : une architecture similaire au cerveau humain.

Dans le sens où elle est constituée d'un réseau de neurones qui font passer ou ne pas passer de l'information en fonction des réponses.

Ce réseau est constitué d'une couche d'entrée et d'une couche de sortie :

L'entrée est la question de l'utilisateur et la sortie est la réponse de ChatGPT dans le cas de cette IA en particulier. Mais les réseaux de neurones artificiels sont utilisés dans la plupart des IA que tu connais comme par exemple Stable diffusion... donc la sortie n'est pas tout le temps du texte.

Il s'est entrainé tout seul sur le Web entier !

Pour nourrir ce LLM qu'est ChatGPT, ses concepteurs lui ont fait s'entrainer tout seul.

C'est un concept qu'on appelle le machine learning. À différencier du supervised learning où les humains sont nécessaires pour guider la machine.

Donc l'IA a appris toutes seules en lisant le Web ou du moins une sélection de celui-ci et notamment des sources de données structurées comme par exemple Wikipedia, des forums...

Mais il a appris à faire quoi ?

La question pourrait te paraître étrange, mais il apprit à deviner des mots que son algorithme d'apprentissage (la partie de l'IA qui joue le rôle de prof) lui cachait.

Par exemple, si je prends un extrait de l'article Wikipedia sur les LLM en anglais

Pour cette phrase "A large language model (LLM) is a type of ??????? model designed for natural language processing tasks such as language generation"

Le model devrait deviner le mot "computational". Peut-être aux premiers essais, il va se tromper, mais son prof IA va lui dire qu'il s'est trompé. Et il va ajuster ses petits poids (les neurones que l'on voit dans le schéma plus haut). Pour arriver enfin à une réponse juste.

Et il fait ça pour des quantités astronomiques de phrases en anglais et dans d'autres langues.

Résultat des comptes de cette phase :

- Il est excellent pour deviner des phrases crédibles

- Il peut parler dans différentes langues et transcrire des concepts dans différentes langues (un apprentissage qui n'était pas attendu et pour lequel on ne l'a pas entrainé)

- Il n'est pas intelligent au sens où on l'entend généralement

En effet, il est très bon pour simuler un texte vraisemblable dans un contexte donné, mais cela ne veut pas dire qu'il comprend le sujet !

Il peut être influencé par les données d'entrée, par exemple le fait que beaucoup de données sont majoritairement en anglais et venant des États-Unis ou des pays occidentaux introduit évidemment un biais.