Les workflows essentiel de Stable Diffusion pour l'architecture

Les IA comme sable Diffusion peuvent être utilisé dans de nombreux workflows très utiles. Découvre ce qui est possible de faire avec l'IA !

Stable diffusion est le modèle d'IA le plus ouvert et le plus puissant.

Tu peux l'utiliser en local, sans que ça ne coûte, sauf l'électricité et les ordinateurs pour le faire tourner !

Il est possible d'utiliser l'IA pour de nombreux cas d'usages de génération ou modification d'images.

Mais pour bien comprendre et savoir comment utiliser l'IA, c'est important de catégoriser ces workflows distincts suivant l'opération que l'on souhaite faire.

On les retrouve dans la plupart des IA qui font des images comme Midjourney, mais pas forcément au complet.

Mais avec Stable diffusion et notamment les interfaces surpuissantes comme ComfyUI, le nombre de possibilités est le plus étendue et on les retrouve donc toutes !

Mais alors qu'elles sont les principaux workflow de l'IA pour les images ?

Et en commençant par celui que tu connais certainement, c'est-à-dire, un prompt textuel génère une image.

La base de l'IA pour les images !

1- Txt2Img :

Générer une image à partir de texte

Dans ce workflow, la donnée d'entrée est du texte et la sortie est une image. C'est le workflow le plus simple, celui que permet n'importe quelle IA qui peut produire des images

C'est l'utilisation la plus classique de Stable Diffusion : générer une image à partir d'une description textuelle.

Étapes :

- Entrée du texte : Rédigez une description précise et détaillée de l’image souhaitée.

- Réglage des paramètres :

- Guidance Scale : Plus la valeur est élevée, plus l'image correspondra à la description.

- Nombre d'itérations (steps) : Influence le niveau de détail (20-50 étapes sont souvent suffisantes).

- Seed : Pour reproduire exactement le même résultat si nécessaire.

- Génération de l'image : Lancez la génération avec le modèle.

- Post-traitement (facultatif) :

- Utilisez des outils comme Photoshop ou un logiciel d'agrandissement pour affiner les détails.

2- Img2Img :

Modification globale d'une image existante

Dans ce workflow, l'entrée est constituée d'une image et d'un prompt, et la sortie une version modifiée de l'image initiale.

Étapes :

- Charger l’image source : Sélectionnez l’image de base.

- Définir une description : Expliquez la transformation ou le style souhaité.

- Ajuster les paramètres :

- Force (Strength) : Contrôle l’influence de l’image d'origine (une force plus basse conserve davantage de l’image originale).

- Générer : Le modèle applique la transformation selon la description.

- Post-traitement (facultatif) : Affinez l'image obtenue si nécessaire.

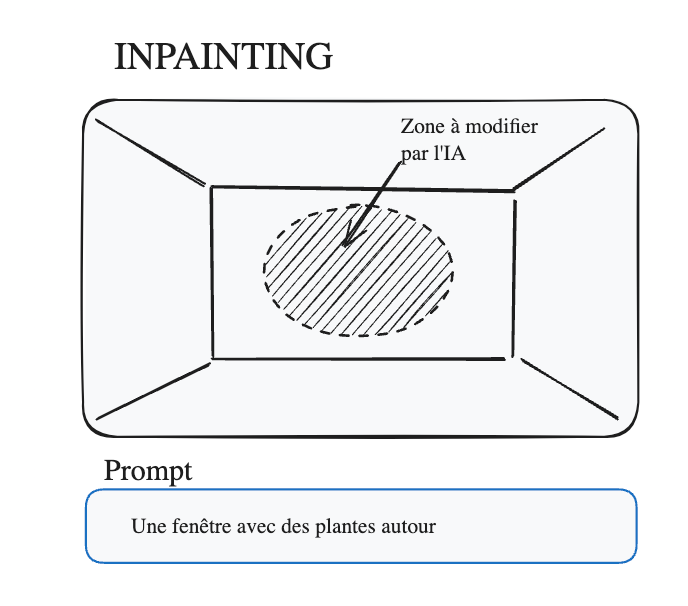

3- Inpainting :

Modification locale d'une image

Le modèle remplace ou complète une partie manquante ou non désirée d’une image.

Étapes :

- Importer une image : Choisissez l’image à modifier.

- Définir un masque : Sélectionnez la zone à retoucher ou remplacer.

- Entrer une description : Décrivez ce qui doit apparaître à la place.

- Réglage des paramètres : Adaptez le guidance scale et le nombre de steps.

- Générer : Le modèle recrée le contenu dans la zone masquée.

4- Upscaling :

Générer de contexte autour d'une image

Dans ce workflow, le but est de mettre à l'échelle une image pour y rajouter du détail.

C'est en fait souvent un pré-requis, sachant que les modèle d'IA générative d'image produise des images relativement petites. Mais c'est également possible de mettre à l'échelle des images qui n'ont pas été généré avec l'IA

À la différence de la fonction taille d'image de Photoshop, les pixels sont vraiment inventés, et donc tu as un nouveau détail qui n'était pas dans l'image d'origine !

Le modèle augmente la qualité et la résolution d'une image tout en conservant les détails et les textures.

Étapes :

- Importer une image : Sélectionnez l’image que vous souhaitez améliorer.

- Choisir le modèle d’upscaling : Optez pour l'algorithme (comme ESRGAN, Real-ESRGAN) adapté à vos besoins.

- Définir les paramètres :

- Facteur d’agrandissement : 2x, 4x ou autre selon la résolution cible.

- Niveaux de netteté ou de réduction de bruit : Adaptez en fonction du rendu souhaité.

- Prévisualiser : Visualisez les résultats avant la génération finale.

- Générer : L'image est transformée en haute résolution avec des détails affinés.

5- Batch Processing

Génération d'images en série ou traitement par lot

Ce workflow est partivulièrement utile pour générer des images en série, et donc tester rapidement plusieurs possibilités. Qui disais que l'IA demandait du temps et de faire des centaines de tests, tu vas pouvoir automatiser ces tests.

Pour générer ou modifier plusieurs images automatiquement.

Étapes :

- Préparer les entrées : Listez les prompts, images ou masques à utiliser.

- Configurer les paramètres : Définissez les paramètres globaux ou par image.

- Lancer le traitement par lot : Automatisez le processus pour tous les fichiers.

- Révision des résultats : Examinez les images générées et affinez si besoin.

6- Outpainting :

Générer de contexte autour d'une image

Dans ce workflow, le contexte de l'image va être étendu pour inventer le contexte autour de l'image. Donc le centre de l'image d'origine va rester inchangé, mais tout un nouveau contexte va être inventé

Ce flux permet d’agrandir une image en générant du contenu qui s’intègre parfaitement aux zones existantes.

Étapes :

- Importer une image : Choisissez l’image de base.

- Agrandir la toile : Étendez les bords pour définir les zones à compléter.

- Entrer une description : Expliquez ce qui devrait remplir les nouvelles zones.

- Réglage des paramètres : Ajustez les détails pour assurer une bonne intégration.

- Générer : Le modèle complète les zones vides.

7- ControlNet

Images de contrôle

ControlNet est un modèle d'IA spéficifique qui vient travailler de concert avec le modèle de diffusion principal et permet de contrôler précisément l'image en respectant notamment des contours (edges)

ControlNet permet d'utiliser des informations structurelles ou contextuelles (poses, croquis, contours) pour guider la génération d'une image par IA.

Étapes :

- Importer une image ou un guide :

- Utilisez une esquisse, un contour, une pose ou une image de référence comme point de départ.

- Sélectionner un modèle ControlNet :

- Différents modèles sont disponibles selon le type de contrôle souhaité (canny, openpose, depth, segmentation, etc.).

- Configurer les paramètres :

- Force de contrôle (Control Weight) : Ajustez la dépendance au guide.

- Guidance scale et steps : Définissez la finesse et le style du rendu.

- Entrer une description (prompt) : Décrivez ce que l’image finale doit représenter (détails, style, contexte).

- Combiner avec le générateur : Le modèle combine les instructions ControlNet et le texte pour générer l'image.

- Générer : Obtenez une image respectant la structure ou les informations initiales tout en étant fidèle à la description.

8- IP Adapter

Transfert de Style

Le principe des IP adapter est de récupérer le style d'une image de base pour faire une image totalement différente

Étapes :

- Charger l’image source : Importez une image.

- Entrer une description : Spécifiez le style ou l’artiste souhaité.

- Réglage des paramètres : Ajustez la force et le guidance scale pour plus de précision.

- Générer : Le modèle applique le style artistique.

- Post-traitement : Améliorez l’image si nécessaire.

Stable diffusion pour les images d'architecture

Si tu souhaites te former à utiliser l'IA pour les images d'architecture, tu pourrais être intéressé par ma formation aux images IA pour les architectes.

Dans cette formation, je t'apprends à créer ton propre système de production d'images avec l'IA en utilisant Stable diffusion. Pour trouver des inspirations, créer des rendus ou modifier rapidement des images avec l'IA.